FineReport与hadoop,hive连接 |

顶( ) |

| 最后更新日期: | 有 人发表评论 (点击查看) |

FineReport与hadoop,hive连接、jdbc连接hive、hive的jdbc连接

1. 描述

Hadoop是个很流行的分布式计算解决方案,Hive是基于hadoop的数据分析工具。一般来说我们对Hive的操作都是通过cli来进行,也就是Linux的控制台,但是,这样做本质上是每个连接都存放一个元数据,各个之间都不相同,这样的模式用来做一些测试比较合适,并不适合做产品的开发和应用。

因此,就产生Hive的JDBC连接的方式。

2. 步骤

2.1 拷贝jar包到FR工程

将hadoop里的hadoop-core.jar、commons-logging.jar拷贝至报表工程appname/WEB-INF/lib下;

将hive里的antlr-runtime.jar、hive-exec.jar、hive-jdbc.jar、hive-metastore.jar、hive-service.jar、jdo2-api.jar、libfb303.jar、log4j.jar、slf4j-api.jar、slf4j-log4j12.jar拷贝至报表工程appname/WEB-INF/lib下。

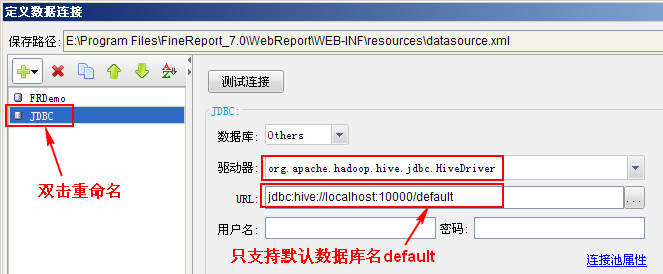

2.2 配置数据连接

启动设计器,打开,新建JDBC连接:

org.apache.hadoop.hive.jdbc.HiveDriver;

jdbc:hive://localhost:10000/default

注:hive服务默认端口为10000,根据实际情况修改端口;另外目前只支持默认数据库名default。

测试连接,提示连接成功即可。

|

|

|

文明发言,用心评论

|

应用此篇文章,您:

不费力

研究了一会 琢磨了好久 |

||

|

Copyright©2019 帆软软件有限公司

苏ICP备18065767号-3 |